論理的思考を強化するELYZAの新モデル「Reasoning Model」の公開

ELYZAが開発した新たなAIモデル

株式会社ELYZAは、最新の言語モデル「ELYZA-Thinking-1.0-Qwen-32B」を発表しました。このモデルは、特に日本語における論理的思考能力を強化することを目的としており、商用利用も可能です。今回は、同モデルの機能や特徴について詳しく解説します。

新モデルの特徴

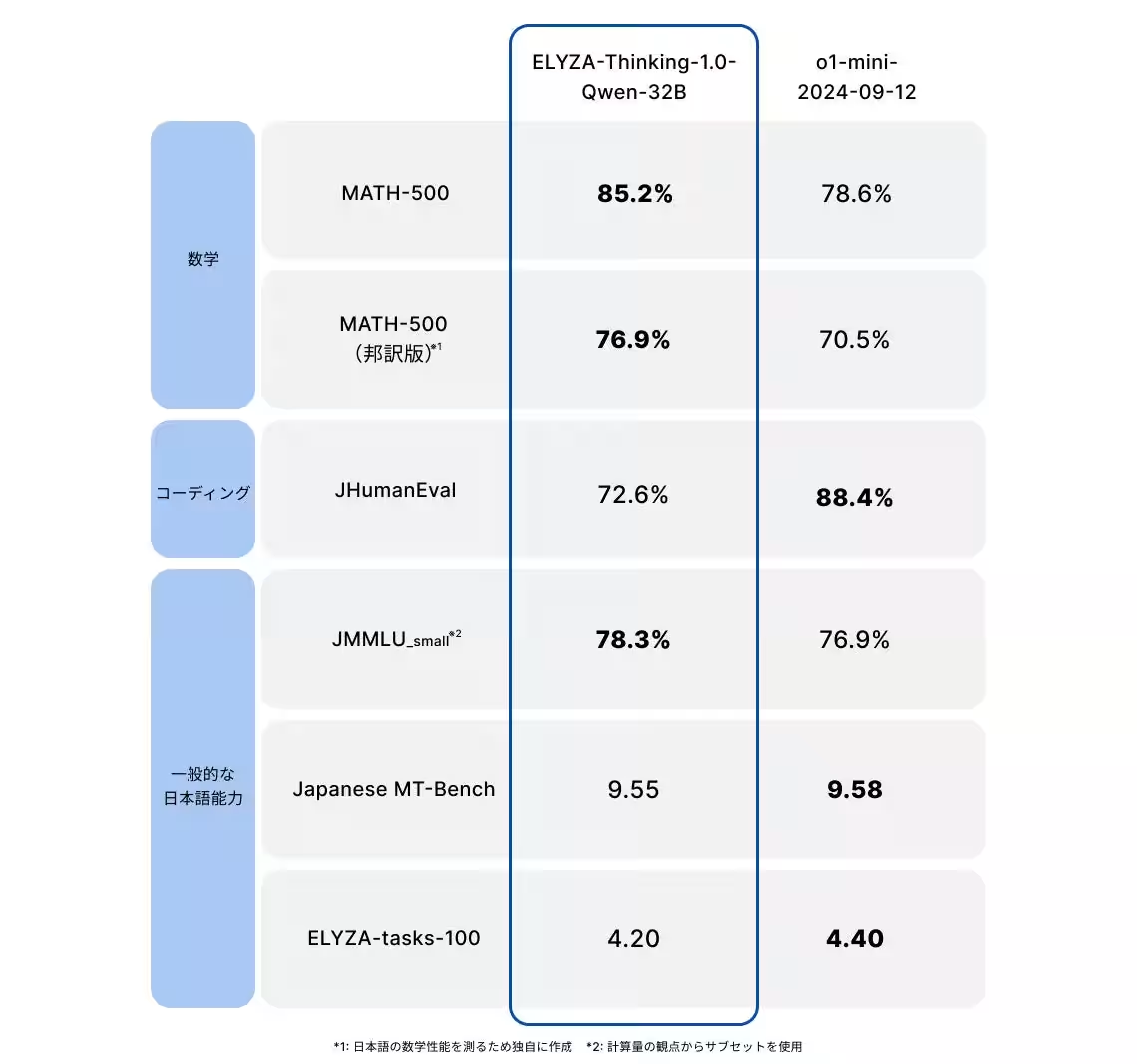

「ELYZA-Thinking-1.0-Qwen-32B」は、320億パラメータを持つ強力な大規模言語モデル(LLM)で、複雑な論理的思考を行う能力を備えています。このモデルは、OpenAI社の「o1/o3」シリーズやDeepSeek社の「DeepSeek-R1」と同様に、思考の連鎖(Chain of Thought; CoT)を通じて高い論理的推論を実現しています。特に、数学的な問題においては抜群の性能を発揮し、日英両方のベンチマークで高得点を獲得しています。

技術的な背景

このモデルでは、日本語の追加事前学習が行われ、より高度な論理的思考能力が付与されています。アリババ社が発表した「Qwen2.5-32B」とは異なり、ELYZAは「非 Reasoning Model」に対して特別に日本語追加学習を行い、その過程で知識を深めています。また、MCTS(モンテカルロ木探索)というアルゴリズムを駆使して、学習データを効果的に生成し、模倣学習を行うことによって、より精度の高い推論モデルを実現しました。

Shortcut Modelの公開

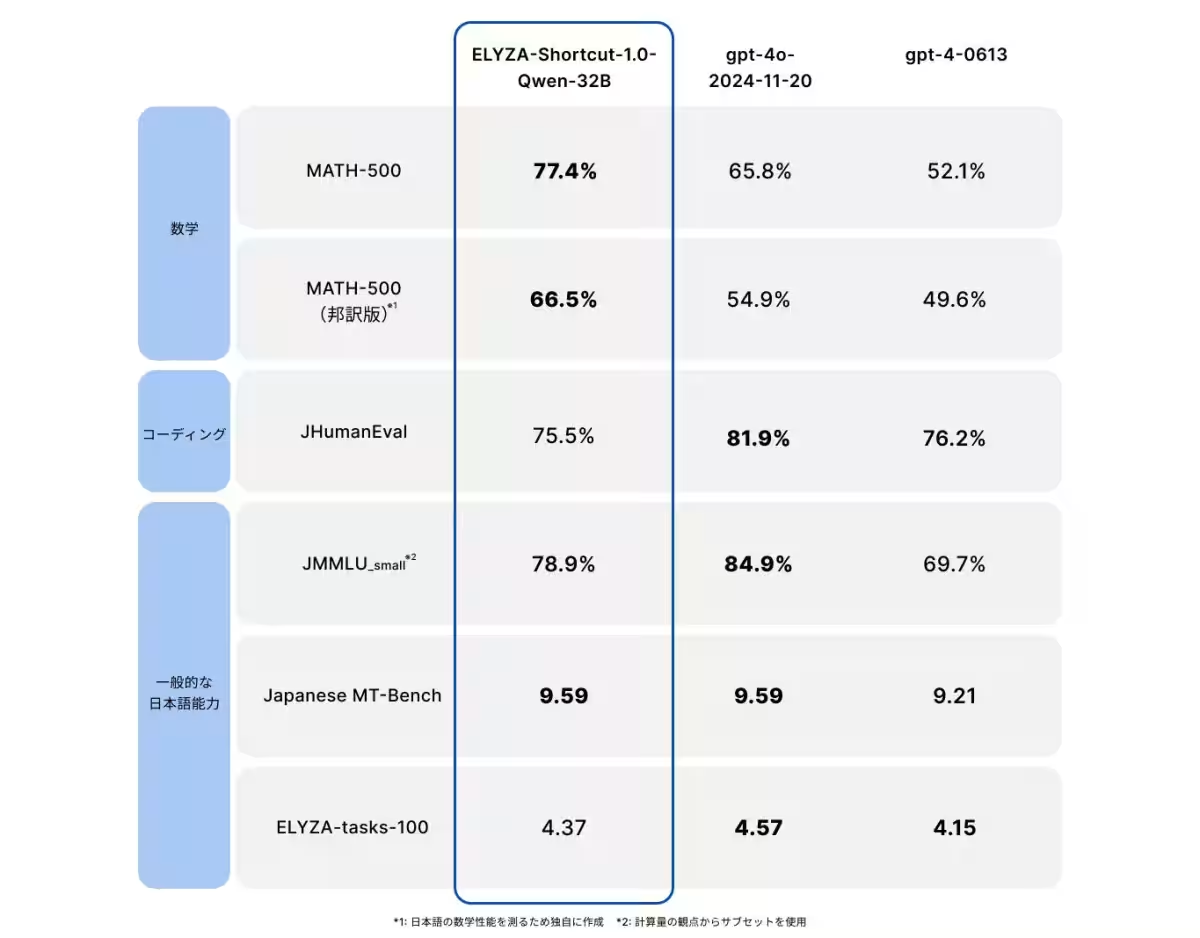

あわせて発表された「Shortcut Model」と呼ばれる2種類のモデルも注目されています。このモデルは、深い思考過程をショートカットして即座に回答を提供できるように設計されています。具体的には、「問題、思考過程、回答」のセットから思考過程を排除した「問題、解答」のペアを用いて開発されました。320億パラメータのモデルと70億パラメータのモデルが提供されており、特に320億パラメータのモデルは、商用APIで展開されているOpenAI社の「GPT-4o」と同等の性能を持っています。

産業への影響

今回のELYZAの成果は、AIエージェントの開発やさまざまな業界での応用が期待され、国内の大規模言語モデルの社会実装を進める起爆剤となるでしょう。また、研究開発の成果を公開することで、自然言語処理技術の進展にも寄与すると考えられます。

今後の展望

ELYZAは引き続き、革新的なAI技術の研究開発に力を入れ、その結果を広く公開していく方針です。今回の「ELYZA-Thinking-1.0-Qwen-32B」によって、日本語の大規模言語モデルが新たなステージに進化したことは、今後の展開に大きな期待を抱かせます。

会社背景

株式会社ELYZAは2018年に設立され、「未踏の領域で、あたりまえを創る」という理念のもと、日本語の大規模言語モデルに特化し、企業との共同研究やクラウドサービスを開発しています。2023年現在、今後の技術革新に向けた基盤を整えています。詳細な情報は公式ウェブサイトおよびテックブログにてご確認ください。

会社情報

- 会社名

- 株式会社ELYZA

- 住所

- 東京都文京区本郷3丁目15-9SWTビル 6階

- 電話番号

トピックス(IT)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。