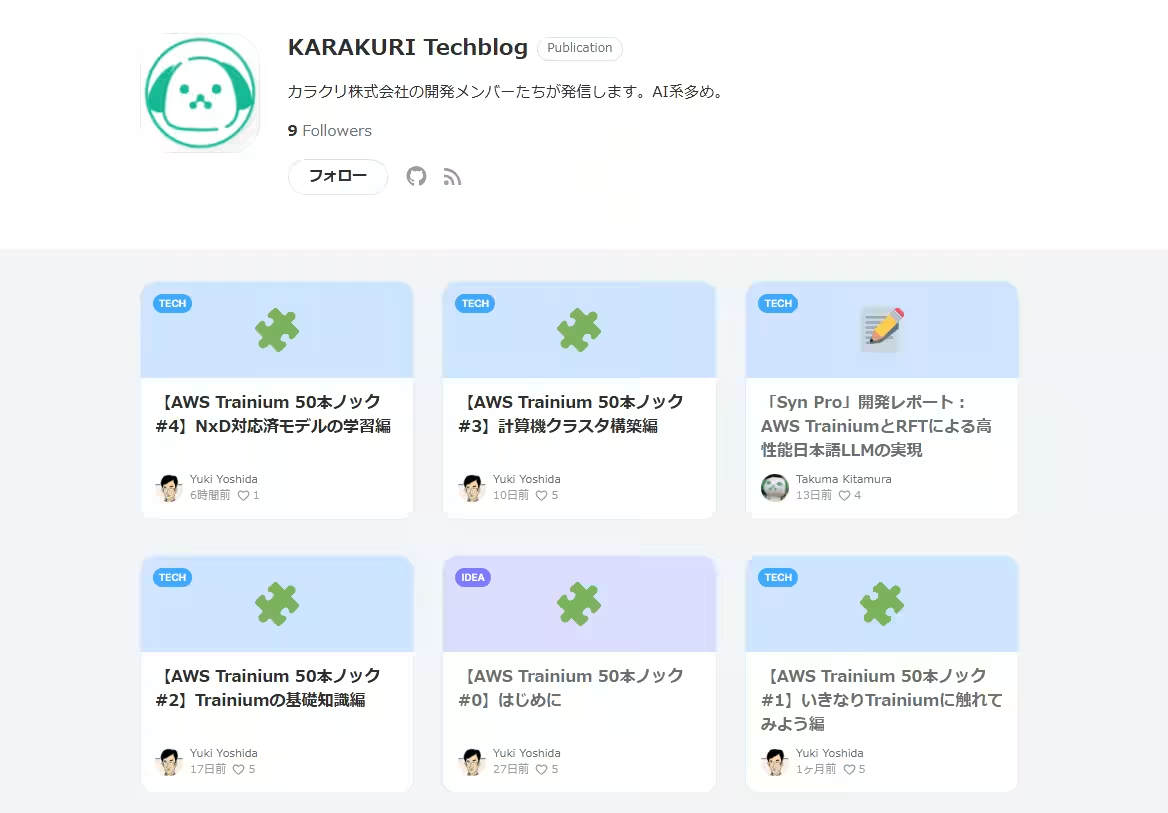

カラクリがAWS Trainium活用法を無償公開!LLM開発の新たな道を切り拓く

カラクリがAWS Trainiumを活用したLLM開発のノウハウを無償公開

カラクリ株式会社(東京都中央区)が、AWSが開発した深層学習特化チップ「AWS Trainium」を利用した大規模言語モデル(LLM)の分散学習およびモデル移植に関する実践的なノウハウを、エンジニアコミュニティ向けに無償で公開しました。この取り組みは、LLM開発を進める多くの技術者にとって大きな支援となるでしょう。

コストとリソースの課題

最近の生成AIブームにより、GPUの高騰が著しく、多くの企業がLLMの訓練やファインチューニングを行う際にコストとリソースに制約を感じています。AWS TrainiumはGPUに比べて優れたコストパフォーマンスを実現しますが、その効果を得るには、特別なSDK(Neuron SDK)の利用や計算グラフの移植など、専門的な知識が必要です。特に、日本語での具体的な実践手順が求められる中、カラクリが発表したノウハウは非常に有益です。

公開されたノウハウって何?

カラクリの公開するノウハウは、下記の要素を含んでいます。これにより、AWS Trainiumを活用するための基礎から応用までを学ぶことができます。対象としているのは、シェル操作やPyTorch、Transformerアーキテクチャの基礎を理解したエンジニアです。

1. AWS Trainium入門と基本

- - トレーニングに最適なインスタンス「trn1.2xlarge」を使ってAWS Trainiumを起動。

- - 「neuron-top」を使ってコアの稼働状況を確認。

- - AWS Trainium特有の遅延評価(Lazy Mode)の挙動について解説。

2. 計算機クラスタ構築

- - AWS ParallelClusterやCloudFormationを使用した大規模学習インフラの構築手順を、一から詳しく解説。

3. LLM分散学習の実装

- - NeuronX Distributed Training (NxDT)を活用した学習環境の構築。

- - チェックポイント変換やAhead-Of-Time(AOT)コンパイル。その後の分散学習の実行手順も解説。

4. 最先端のモデル移植技術

- - Llama 3ベースモデルをターゲットにしたNxDTのカスタム並列層を利用したモデルアーキテクチャの移植手順を詳細に解説。

5. 分散学習の理論

- - データ並列、テンソル並列、パイプライン並列などの分散学習戦略の原理と、そのAWS Trainium環境への適用方法についての説明。

この中でも特に、Llama 3ベースのモデル移植は、新しいアクセラレータ上で新モデルを動かす際には欠かせないノウハウであり、LLM開発の幅を広げることが期待されます。

今後の展望と継続的な支援

カラクリは、本ノウハウを通じて得たフィードバックや知見を基に、技術課題の解決やイノベーションを推進します。今後は、AWS Trainiumの次期バージョン「Trn2」への対応など、最新のテクニックをコミュニティに還元していく予定です。

会社概要

カラクリは、AIスタートアップとして「FriendlyTechnology」というビジョンの下、大規模言語モデル(LLM)をカスタマーサポートに実用化しようと努力しています。2018年にトランスフォーマーモデルのBERTの研究を開始し、2022年からGPTを含むLLMの開発へと進化。この分野での実践を通じて、高島屋やSBI証券、セブン-イレブン・ジャパン、星野リゾートといった名だたる企業に選ばれてきました。カラクリの目指す未来を見逃さないでください!

会社情報

- 会社名

- カラクリ株式会社

- 住所

- 東京都中央区築地2-7-3CAMEL 築地2 5F

- 電話番号

トピックス(IT)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。