GMOインターネットが「NVIDIA B300 GPU」の圧倒的性能を実証、生成AI開発に最適な環境を提供

GMOインターネットが「NVIDIA B300 GPU」の性能を実証

GMOインターネット株式会社(CEO:伊藤 正)は、新たに導入した「NVIDIA B300 GPU」を搭載したGPUクラウドサービスの性能評価を行った。この評価は、2024年11月から提供が開始される「NVIDIA H200 Tensor コアGPU」との比較も含まれており、生成AI開発における実用性を示す重要なデータを提供している。

実施したベンチマークの概要

性能検証は、以下の3つのベンチマークテストによって行われた:

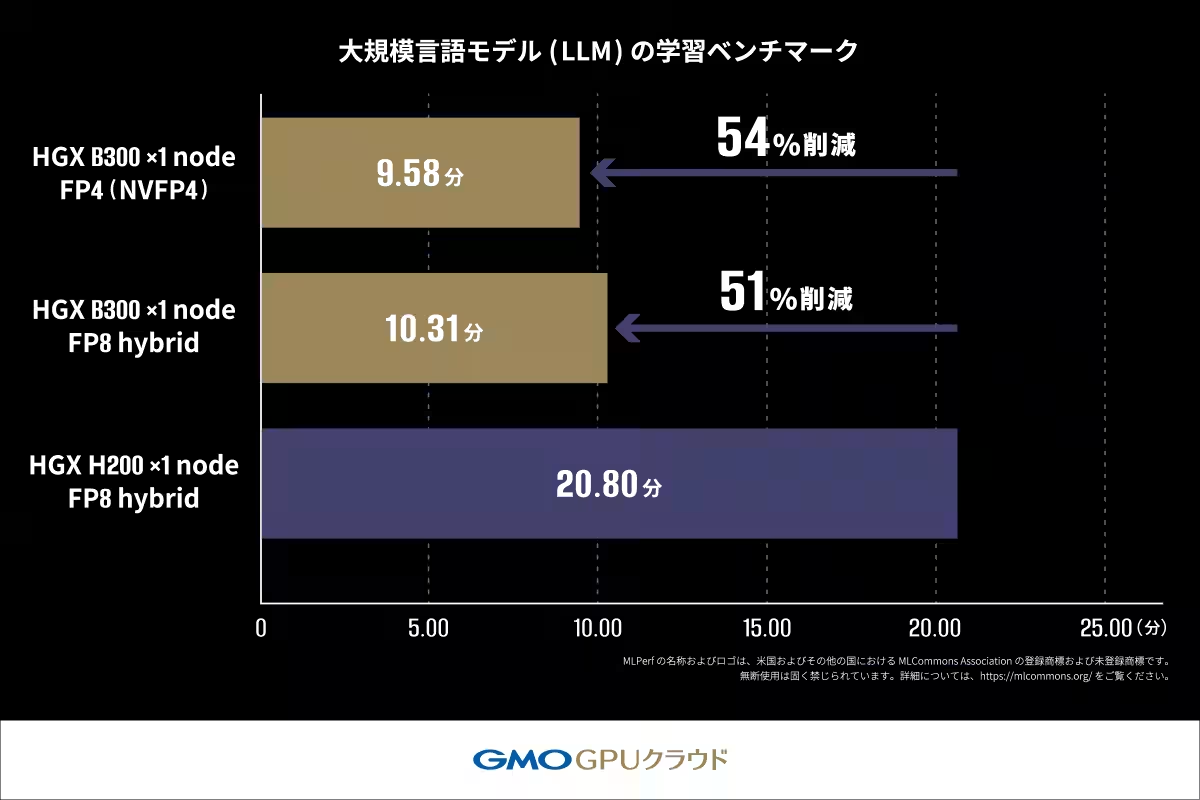

1. 大規模言語モデル(LLM)の学習ベンチマーク:

- 学習効率と演算速度を評価し、実際にLLMをファインチューニングして学習完了時間を測定。目標の品質に達するまでの時間を比較した。

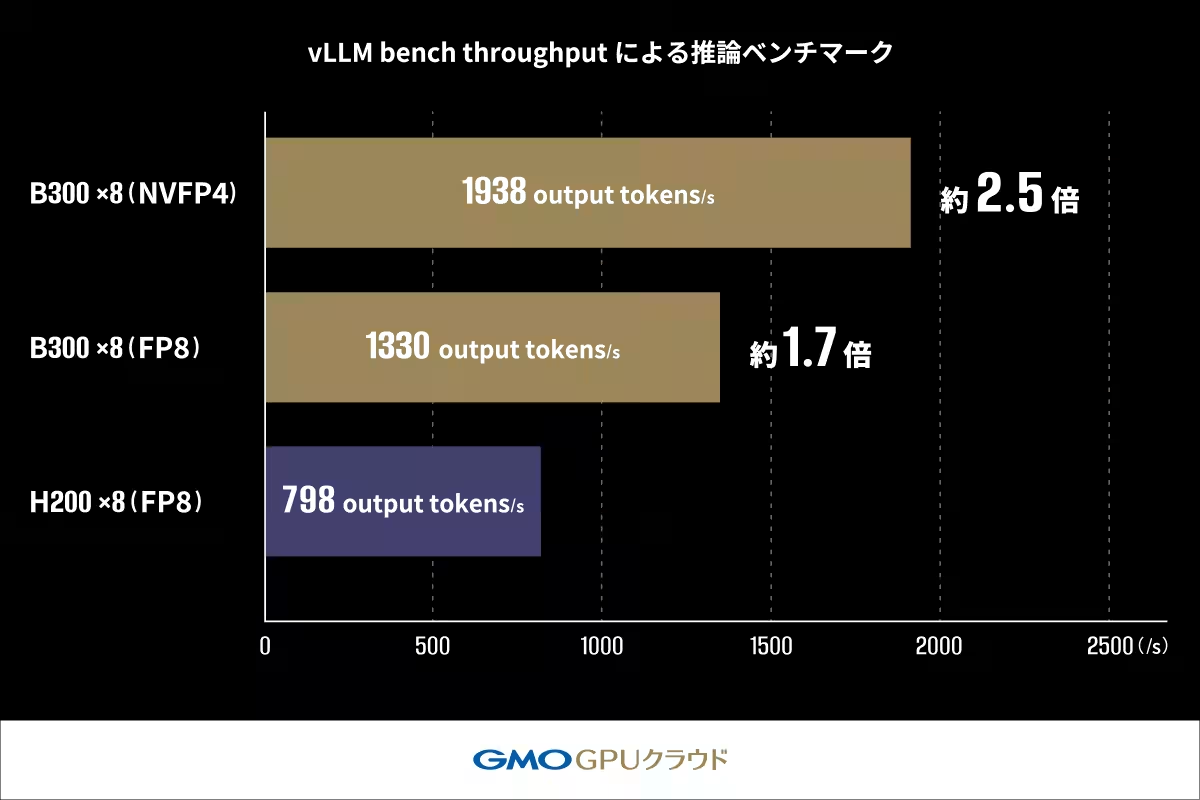

2. vLLM bench throughputによる推論ベンチマーク:

- 単位時間内に生成可能なトークン量を評価。高速化されたバッチ処理における推論性能を測定した。

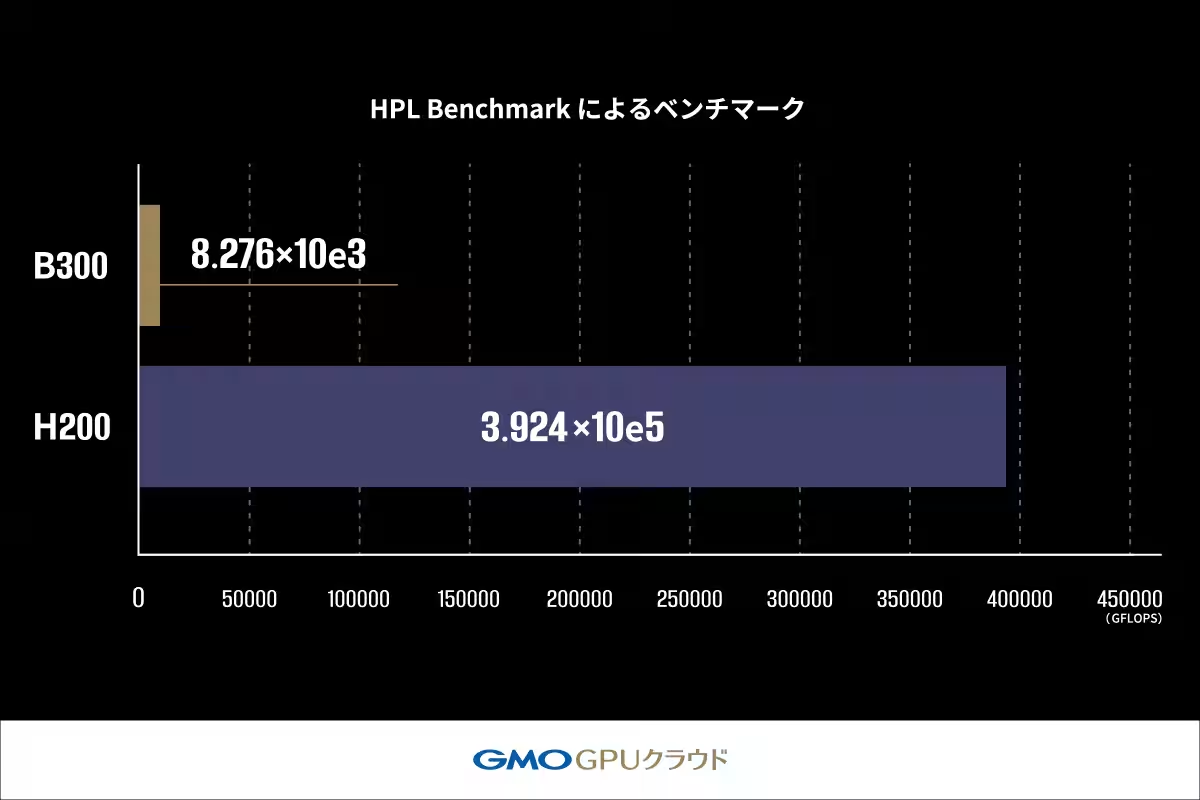

3. HPL Benchmarkによる高精度な数値計算の処理能力評価:

- 密行列の連立方程式を解く処理を通じて、浮動小数点演算性能を測定した。

これらのテストによって、「B300 GPU」は生成AIの開発から運用において強力なパフォーマンスを発揮することが確認された。

ベンチマーク結果の詳細

1. 学習ベンチマークでは、MLPerfの規定に基づき「Llama2 70B」モデルを使用。H200 GPUの学習時間は20.80分だったのに対し、B300 GPUは10.31分で完了し、約2倍の速度を記録。さらに、FP4を用いることで学習時間がさらなる短縮が見込まれる。

2. 推論ベンチマークでは、Llama-3.1モデルの出力トークン数を測定した結果、H200 GPUは798 tokens/sであったのに対し、B300 GPUは1330 tokens/sと約170%の性能向上を示した。FP4を適用した場合には1938 tokens/sまで向上し、推論での処理性能は約250%の向上があった。

3. HPL Benchmarkでは、B300 GPUはH200 GPUに対して約2.1%の性能しか示さなかった。これは、B300 GPUが生成AIワークロードに最適化された結果であり、高精度な処理を必要とする科学技術計算ではH200 GPUが依然として有用であることを示している。

GMOインターネットの今後の展望

GMOインターネットは、このベンチマーク結果を基に生成AIを利用する企業や研究機関に、適切なGPUクラウドサービスを提供することを目指している。生成AIに特化したB300 GPUと、高精度計算に対応するH200 GPUをそれぞれの用途に応じて柔軟に提案し、顧客のニーズに応える。本サービスを通じて、日本のAI産業の発展に貢献できることを目指している。

総括

GMOインターネットが提供する「GMO GPUクラウド」は、NVIDIAの最先端技術を活用しており、今後ますます発展することが期待される。生成AIの進化に寄与するこのサービスは、ユーザーがより効率的にAIを活用できる環境を提供する。若干の調整をしながら、最適な計算資源を提供し続ける意思を強調する。

詳細については公式サイトを参照されたい:GMO GPUクラウド

会社情報

- 会社名

- GMOインターネットグループ

- 住所

- 東京都渋谷区桜丘町26-1セルリアンタワー

- 電話番号

- 03-5456-2555

関連リンク

サードペディア百科事典: 東京都 渋谷区 GMOインターネット GPUクラウド NVIDIA B300 GPU

Wiki3: 東京都 渋谷区 GMOインターネット GPUクラウド NVIDIA B300 GPU

トピックス(IT)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。