ストックマークが開発した日本語LLMをNVIDIA NIMで提供開始、実務利用の壁を突破

ストックマークが開発した日本語LLMをNVIDIA NIMで提供開始

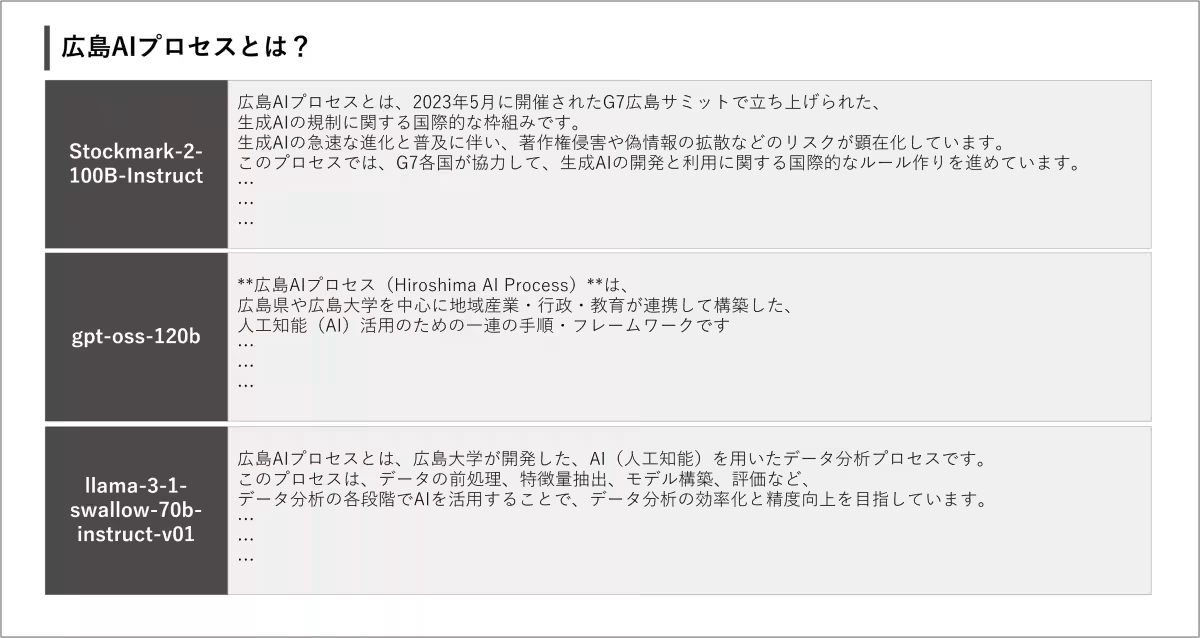

日本のAIスタートアップ、ストックマークが独自に開発した1000億パラメーターに及ぶ日本語大規模言語モデル(LLM)「Stockmark-2-100B-Instruct」が、NVIDIA NIMマイクロサービスを通じて提供されることが発表されました。これは特に日本市場向けに設計されており、AI技術の進化を実感できる画期的な進展といえます。

LLMの実務活用における課題

大規模な言語モデルの導入は、企業にとって一筋縄ではいかないものです。推論やファインチューニングには高額なGPU環境が不可欠であり、導入コストの負担が企業の足かせにもなります。また、ユーザーが増加すれば、レスポンスの遅延やシステム負荷の問題がさらに浮上することがあります。これだけでなく、データの機密性や安定した運用環境の構築も重要です。LMMの高い性能にもかかわらず、実務での安全で効率的な活用には多くの障壁が立ちはだかっています。

これを打破するために、NVIDIA NIMマイクロサービスが誕生しました。このマイクロサービス群は、AIモデルを本番環境に適応させる効率的な手段を提供し、開発者と企業に新しい可能性をもたらします。クラウドやデータセンター、ワークステーションなど、さまざまな環境での導入を簡素化し、時間の節約にも貢献します。

日本語特化型モデル「Stockmark-2」の登場

Stockmark-2は、ストックマークがフルスクラッチで開発した日本語特化型のLLMです。従来はオープンソースの既存モデルをベースにした開発が主流でしたが、ビジネスの文脈理解に必要な精度や独自性を追求するため、独自の設計を選びました。このモデルは、日本語のビジネス文書や会話文をトレーニングデータとして使用し、NVIDIAの技術とリソースを活かして開発されました。

日本語特有の文脈に強いStockmark-2は、業務利用においても高い安定性と精度を誇ります。これにより、ビジネスシーンでの意思決定支援がよりスムーズに行えるようになります。

ストックマークのビジョン

ストックマークのCTO、有馬幸介氏は、NIMを使用することでStockmark-2の動作効率が最大2.5倍向上すると述べています。これにより、大規模なモデルを使用する際のハードルが低くなり、国内クラウドやオンプレミスでの運用が容易になります。日本語LLMの活用が一段と普及し、専門性が求められる分野での実用化が進むことが期待されています。

今すぐ試せる環境

開発者は早速、NVIDIA APIカタログからNIMを用いたモデルを試すことができます。Kubernetesを利用すれば、主要なクラウドプロバイダーやオンプレミス環境への迅速なデプロイも可能です。NVIDIAのマネージドクラウドのAPIを介して、簡単にStockmark-2を利用できる準備が整っています。

この新たな技術基盤は、日本のビジネス環境におけるLLMの活用をリアルタイムに進化させ、信頼性とセキュリティを兼ね備えたアプリケーション開発を可能にします。ストックマークによる開発の成功事例は、今後のAIの進展に大きな影響を与えることでしょう。

会社情報

- 会社名

- NVIDIA

- 住所

- 東京都港区赤坂2-11-7ATT New Tower13F

- 電話番号

トピックス(IT)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。