Nejumi LLMリーダーボード4がもたらす最先端評価基準の進化

Nejumi LLMリーダーボード4の概要

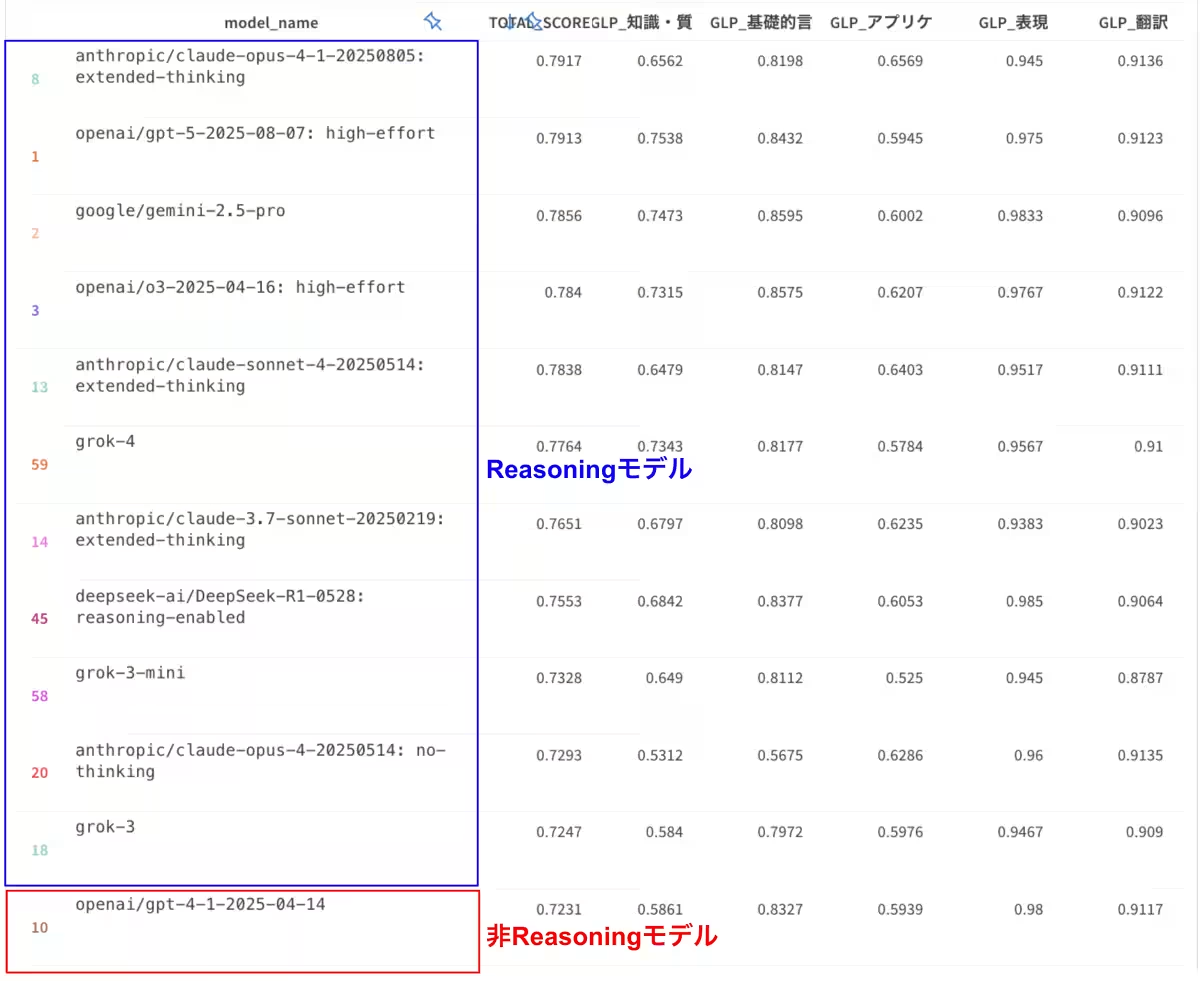

日本最大級のLLM(大規模言語モデル)比較サイト「Nejumi LLMリーダーボード」が3回目のメジャーアップデートを発表しました。Weights & Biases Japan(W&B Japan)が手掛けたこのアップデートでは、急速に進化するAIモデルに対応した新たな評価基準の導入が行われました。特に、推論、知識、アプリケーション開発能力、安全性評価の各カテゴリにおいて、より実践的で高難度な課題が追加されています。これにより、企業や研究者がLLMモデルを選定する際に有用な指標が提供されます。

アップデートの背景

LLMの性能向上は続いており、従来のベンチマークではモデル間の差別化が難しくなっています。このような状況を踏まえ、デベロッパーや企業でのアプリケーション開発に必要な能力を適切に評価する新たな基準が求められています。また、AIの安全性に対する関心が高まる中、AIガバナンスにも対応した評価が必要とされています。今回のNejumi LLMリーダーボード4では、これらのニーズに応えるため、評価フレームワークが大幅に拡充されました。

新たな評価項目

1. 高難易度な推論ベンチマーク

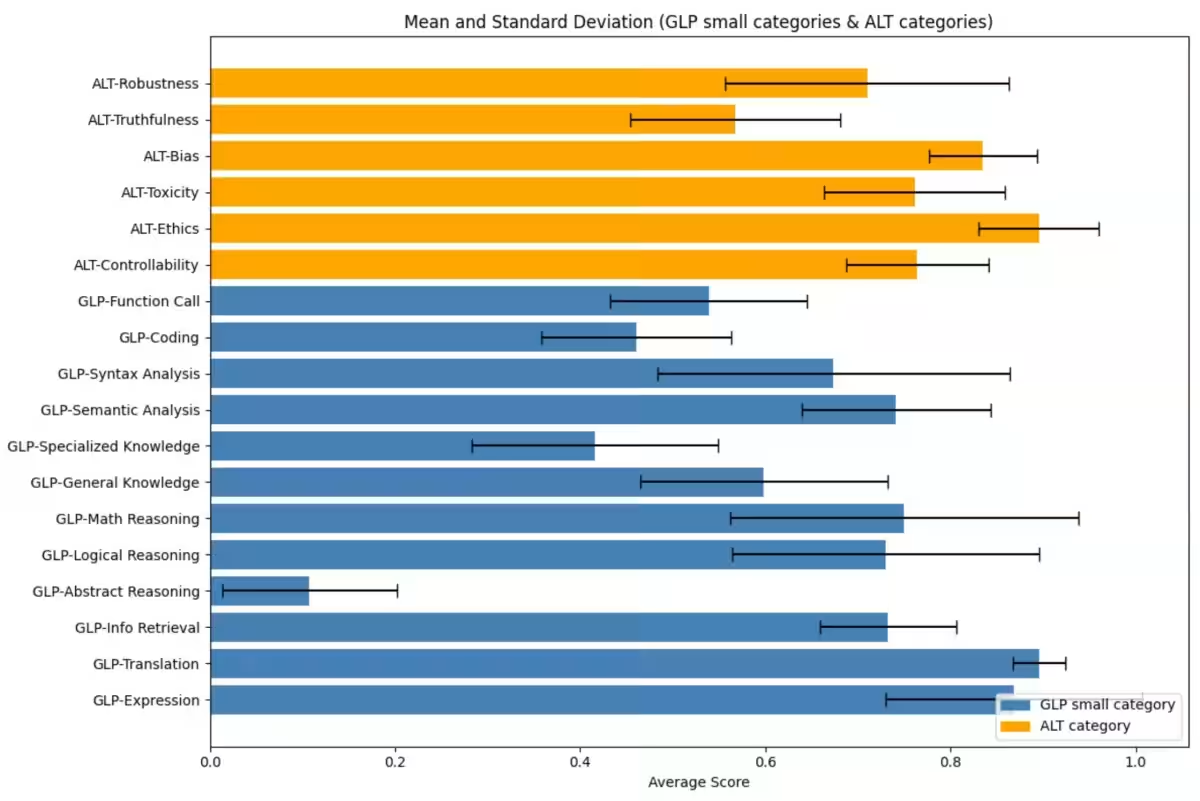

近年リリースされた先端モデルの特性を反映し、数学的推論や抽象的な課題に対応する能力を測るために、ARC-AGIおよびARC-AGI-2といった新たなベンチマークが追加されました。

2. 深い知識が必要な問題

質問回答系ベンチマークにおいては、従来のスタンダードから更に進化し、JMMLU-ProやHumanity's Last Examを新たに導入して、専門的知識を必要とする高度な評価が可能となりました。

3. アプリケーション開発能力の評価

LLMの単体評価から、より複雑なアプリケーション開発における評価が可能な新たなカテゴリーを設立。プログラミング能力を評価するSWE-Bench Verifiedや日本語でのコード生成を測るJHumanEval、対話的コーディングタスクを評価するMT-Bench Codingが追加されました。

4. 安全性評価の強化

生成AIの安全性を重視し、特に実用面で評価の再現性を保証するためのライセンスベンチマークが追加。この取り組みにより、評価の精度が高まりました。M-IFEVALやHalluLensといったデータセットも新たに追加されています。

エンタープライズ利用の促進

Nejumi LLMリーダーボード4はオープンソースで利用可能であり、企業はプライベート環境で評価を実施することが容易になりました。評価の迅速化やインターフェースの統一により、自社モデルやプロンプトの評価も簡単に行えるようになっています。また、エンタープライズライセンスを持つ企業向けには、有償でプライベートリーダーボードの構築支援も行っています。

インタラクティブな分析機能

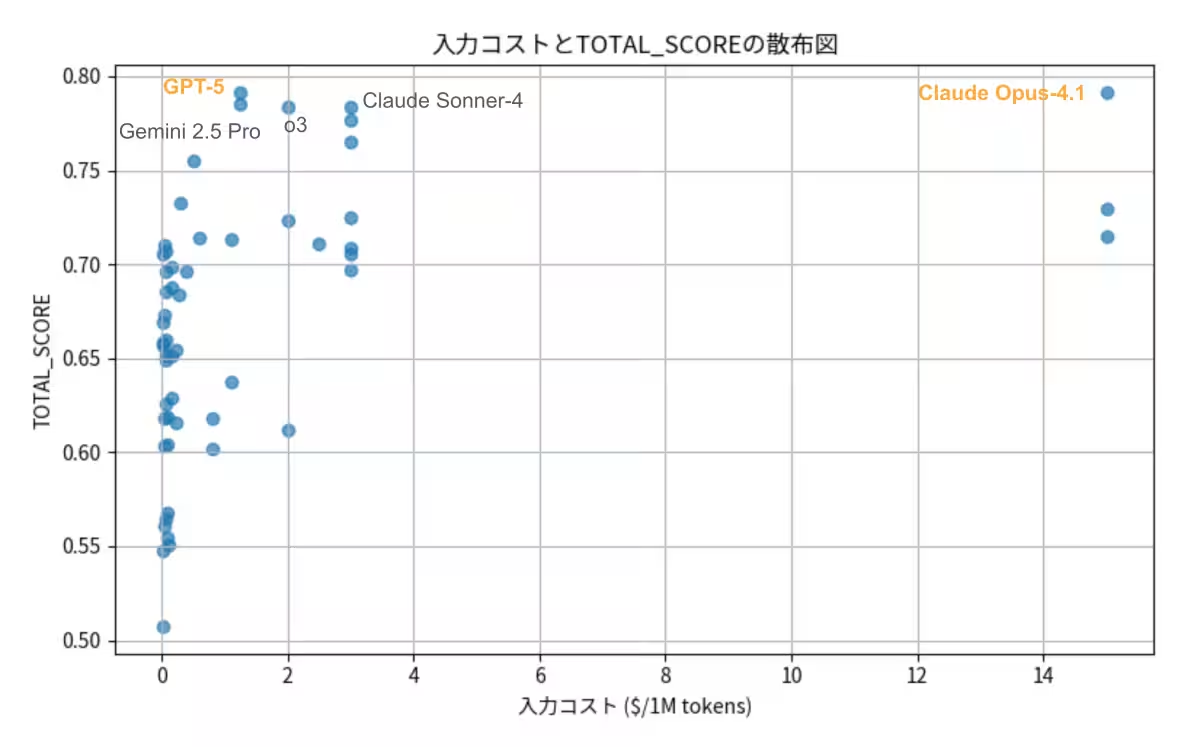

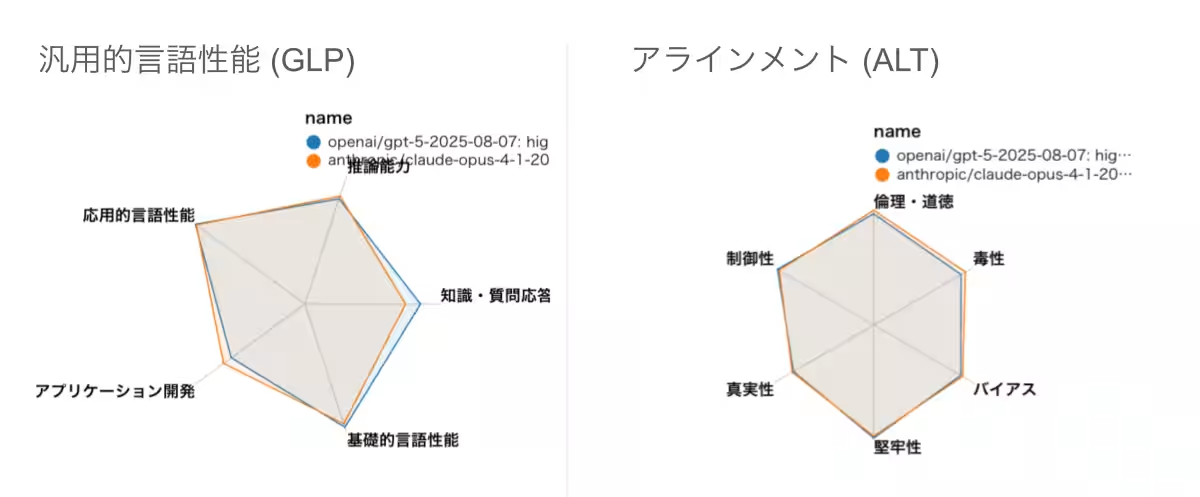

W&Bプラットフォームの機能を活用し、評価結果のインタラクティブな分析が可能です。モデル間の詳細な比較や用途別の性能バランスの可視化など、実用的な意思決定を支援する機能が提供されています。

今後の展望

LLMにおける性能差を明確にすることで、企業はより納得のいく選定を行えるようになりました。GPT-5とClaude Opus 4.1の比較においても、両者の性能は接近しているものの、それぞれの強みが鮮明になっています。特にアプリケーション開発や深い知識を要するタスクにおいてのパフォーマンスは、今後のモデル選定において重要な要素となるでしょう。

このように、Nejumi LLMリーダーボード4は最新のAIモデル評価の新基準を設定し、今後のAI開発における重要な一歩となることが期待されます。

会社情報

- 会社名

- Weights & Biases Japan 株式会社

- 住所

- 東京都中央区京橋3-1-1 東京スクエアガーデン14F

- 電話番号

- 080-4875-0884

関連リンク

サードペディア百科事典: Nejumi LLMリーダーボード Weights & Biases Japan 統合AI評価

トピックス(IT)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。