言語処理学会でのYAMALEXチームの活躍とAI技術の進化

YAMALEXチームが言語処理学会での名誉を獲得

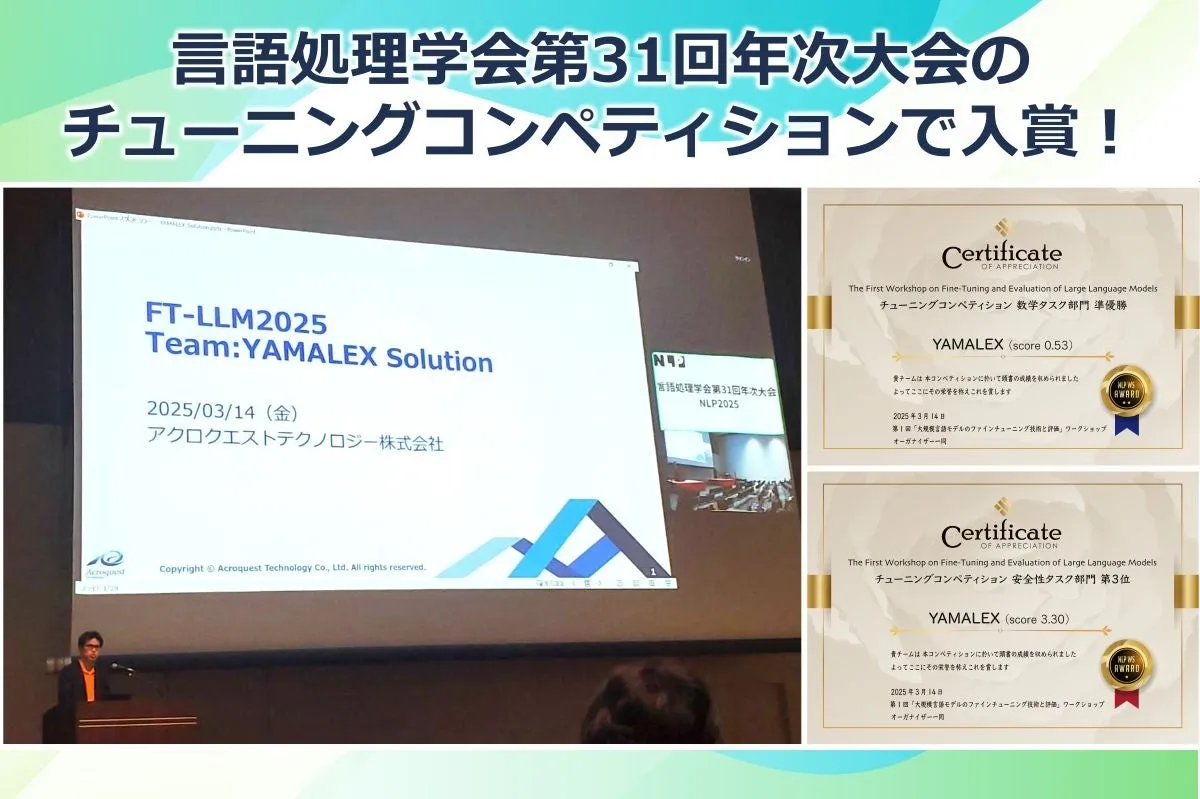

2025年3月、言語処理学会第31回年次大会(NLP2025)において、アクロクエストテクノロジー株式会社のデータサイエンスチームYAMALEXが、注目のファインチューニングコンペティションで素晴らしい結果を収めました。この大会では、言語処理における大規模言語モデル(LLM)のファインチューニング技術が議論され、YAMALEXはその中で両部門に見事入賞を果たしました。

第1回「大規模言語モデルのファインチューニング」ワークショップとは

今回のワークショップは、ファインチューニング技術に関心を持つ研究者たちが集まり、技術を競う場として設定されました。具体的には、安全性と数学能力に関する2つのチューニングタスクが実施されました。

- - 安全性チューニングタスク:ここでは、安全性を意識したQAデータセットを用い、安全でかつ有用な応答を提供できるようチューニングを行います。

- - 数学チューニングタスク:算数や数学の問題を解く能力を高めることを目的として、適切なテストデータを基に評価が行われます。

YAMALEXの成果

全体で18チームが参加したこのコンペティションにおいて、YAMALEXは特に注目されました。安全性タスクでは第3位、数学タスクでは準優勝を獲得。これは、今までにない技術的アプローチによるものであり、参加メンバーが一丸となって取り組んだ結果です。チームリーダーの山本は、特に数学タスクでの挑戦が難しかったことや、LLMに必要な思考過程を与える重要性について触れました。彼は「コード生成を通じて、LLMの能力を引き出し、精度を向上させることができた」と自信を見せました。

また、機械学習エンジニアの佐々木も、リソース制約の中での13Bモデルのファインチューニングに関する貴重な学びについて述べています。彼らのコメントからは、今回のコンペティションがチームにとってどれほど成長の機会だったかが伺えます。

今後の展望

アクロクエストテクノロジー株式会社は、今後もAIや機械学習の技術向上に努め、お客様の課題解決に取り組む姿勢を崩すことはありません。YAMALEXチームの受賞は、ただの結果ではなく、さらなる技術革新への出発点でもあるでしょう。

私たちは、言語処理やAI技術の進化を見守りながら、社会に貢献していけることを期待しています。また、言語処理学会の公式サイトや発表資料も参考にして、今後の動向を追っていきたいところです。

言語処理学会第31回年次大会(NLP2025)の詳細や、YAMALEXチームの取り組みに関心がある方は、こちらのリンクを参考にしてみてください。

会社情報

- 会社名

- アクロクエストテクノロジー株式会社

- 住所

- 神奈川県横浜市港北区新横浜3-17-2友泉新横浜ビル5F

- 電話番号

- 045-476-3171

トピックス(IT)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。