HPCシステムズ、NVIDIA最新GPU搭載ソリューションでローカルLLMの導入を加速

HPCシステムズが新たに提供するローカルLLM導入ソリューション

HPCシステムズ株式会社は、このたび新たにNVIDIAの最新Blackwellアーキテクチャを搭載したGPUサーバー「HPC5000-XGRAGPU8R10S-NVL」を中心としたローカルLLM(大規模言語モデル)環境の導入支援を開始しました。このターンキーソリューションは、特に高まるローカルLLMの需要に対応するために設計されています。現在、企業や研究機関では、大規模言語モデルを自身の環境で運用することが求められており、本ソリューションはそのニーズに応えるものです。

バックグラウンド

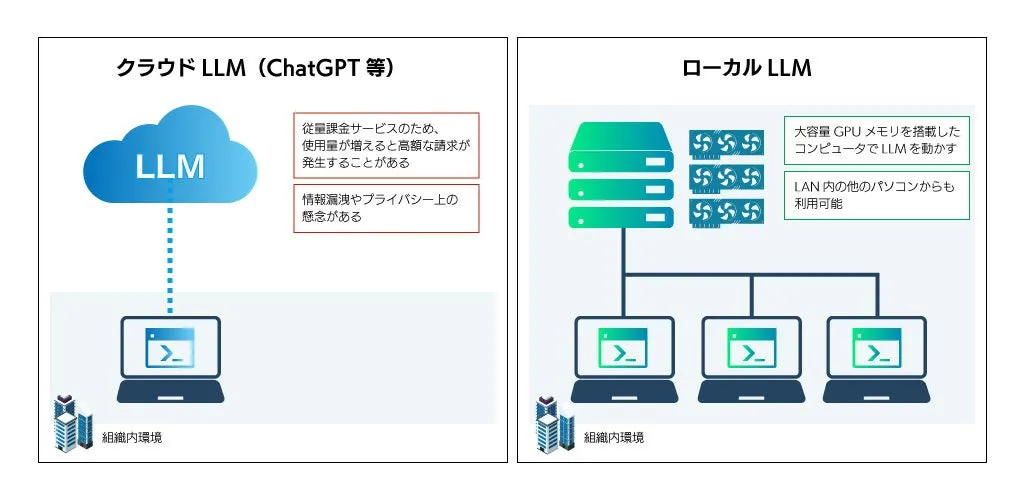

ChatGPTの登場以降、ローカルLLMを利用したいという声が増えています。特に、自社内でのデータ管理やプライバシー、そしてセキュリティを重視する企業にとって、ローカルLLMは魅力的な選択肢となっています。クラウド型のサービスに比べ、ローカルLLMは従量課金が発生せず、情報漏洩のリスクがないため、機密性の高い情報を扱う場合にも最適です。

さらに、最近では、高度なタスクに対しても対応可能な数百億から数千億パラメータの高性能LLMへの需要が急増しています。このようなモデルでは、自然な文章生成や複雑な推論が求められ、研究や開発、顧客対応などでの利用が期待されています。しかし、高性能LLMを運用するには、特殊なコンピュータと大容量のGPUメモリが必要であり、その導入障壁が課題となっていました。

本ソリューションの特徴

この新しいソリューションは、最新のハードウェアとソフトウェアが一体化されている点が特徴です。具体的には、NVIDIA HGX B200 GPUを8基搭載したサーバーで、合計1.4TBに及ぶGPUメモリを実装しています。このメモリ容量は、MetaのLlama 3などの最大モデルの推論に必要なメモリを大幅に上回っており、将来的なLLMの進化にも柔軟に対応できる構成です。

さらに、サーバーには主要LLM関連のソフトウェアが事前にインストールされており、複数チームでのリソース共有やジョブ管理も容易です。また、導入時から運用後の技術サポートまでトータルでサポートする体制も整っています。HPCシステムズは、NVIDIAの「ELITE PARTNER」として、専門知識を持ったスタッフが対応します。

導入のメリット

本ソリューションの導入により、企業は導入期間を短縮できるだけでなく、専門知識がない事業者でもスムーズに運用できるようになります。また、外部委託と比べてコスト削減にも貢献でき、安定した運用を実現します。最新技術を活用することで、最前線の研究開発にも対応できるようになります。

今後の展望

HPCシステムズは、今回のソリューションを基に、LLMに関連する研究開発を支援するための新たな製品やサービスを今後展開する予定です。高性能なLLMの需要がますます高くなる中、このソリューションは多くの企業や研究機関にとって貴重な選択肢となるでしょう。

HPCシステムズについて

HPCシステムズは、ハイパフォーマンスコンピューティングの分野に特化した企業で、科学技術計算やディープラーニング環境の構築、計算化学やマテリアルズ・インフォマティクスに関するサービスをワンストップで提供しています。これからも、さまざまなソリューションを通じて、企業の研究開発を支え続けることが期待されます。

会社情報

- 会社名

- HPCシステムズ株式会社

- 住所

- 東京都港区海岸3-9-15LOOP-X 8階

- 電話番号

- 035-5446-5530

トピックス(IT)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。