Axcxept株式会社が発表した新たな数学推論特化型LLM「QwQ-32B-Distill-Qwen-1.5B-Alpha」

Axcxept株式会社が発表した新たな数学推論特化型LLM「QwQ-32B-Distill-Qwen-1.5B-Alpha」

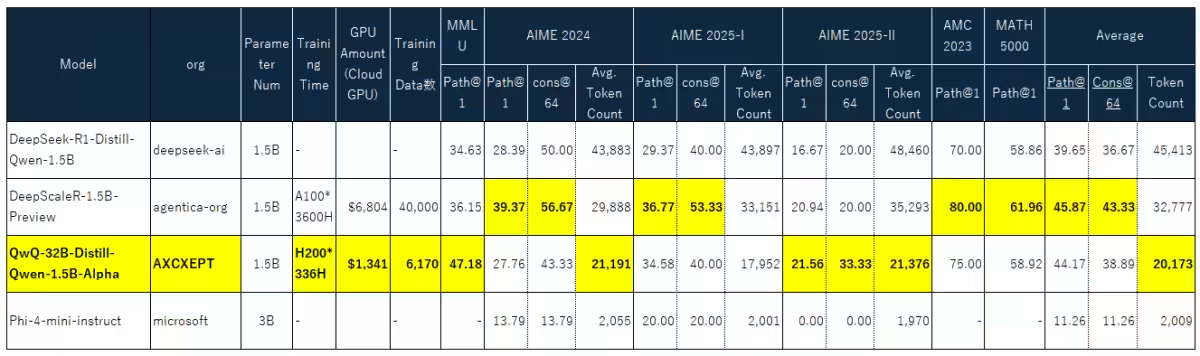

Axcxept株式会社が、数学推論に特化した超小型言語モデル「QwQ-32B-Distill-Qwen-1.5B-Alpha」をオープンソースで発表しました。この新モデルは、わずか2日間の強化学習により、数学の推論能力を大幅に向上させています。これは、深層学習(Deep Learning)の分野において大きなニュースであり、特に学術やビジネスの現場でのAI活用に大きな影響を与えるでしょう。

技術的背景とインスピレーション

「QwQ-32B-Distill-Qwen-1.5B-Alpha」は、deepseek-aiが開発した長考型モデルの技術や、米国のバークレー大学が進める「DeepScaler」プロジェクト、さらにアリババクラウドが提供する「QwQ-32B」からインスピレーションを受けています。このような数々の先行研究やモデルをベースに、コストを抑えながらも高い推論性能を持つことを実現しました。

これまでAxcxept株式会社は、日本語特化型や金融・セキュリティ分野に特化したLLMを開発してきましたが、この新たなモデルは、その集大成とも言える革新的な開発成果です。長考型の最先端LLM「DeepSeek」の知見を取り入れて作り上げられた本モデルは、1.5Bという非常に小型でありながら、高い性能を持っていることが特徴です。

性能と実用性

実際の性能を測る指標として「MMLU」ベンチマークにおいて、47.18という高スコアを記録しています。また、数学競技問題であるAMC 2023では75%的な正解率も達成。これは、あらゆる数学関連業務において、小型モデルが従来の大規模モデルに匹敵する能力を持つことを証明しています。

さらに、トレーニングにはH200 GPUを336時間かけており、コストは約1,341ドルという非常に低いリソースコストです。これにより、企業や教育機関にとっても実用化が容易になっています。

オープンソース公開の意義

Axcxeptは、AI技術を広く普及させるために、このモデルをHugging Face上で無償公開します。誰でもダウンロードでき、商用利用も可能です。実際に使用されることで、より多くの企業や研究機関が先進的なAI開発を行うための一助となることでしょう。

公開先へのリンク(Hugging Face)

今後は、さまざまな小型モデルに対するニーズに応えるため、さらなる研究開発を進めていくとしています。また、現在の成果に基づいたデータセットの公開も予定されています。

未来への展望

Axcxept株式会社は、企業の特化型モデルの開発と社内AIソリューションの提供を広く行っています。この活動は国内のみならず、最近香港で開催された「JUMPSTARTER」でも出展し、国内外の信頼を獲得しました。Axcxeptは、北海道から日本全体をAIに強い国にするため、代表のホーダチKazuya氏が先頭に立って邁進しています。

今後もさらなる技術革新を目指し、積極的に新たなAIソリューションを提供していくでしょう。

【本件に関するお問い合わせ】

Axcxept株式会社

担当:代表 Kazuya Hodatsu

Email:[email protected]

X:@hokazuya

会社情報

- 会社名

- Axcxept株式会社

- 住所

- 北海道札幌市白石東札幌5条1丁目1-1

- 電話番号

トピックス(IT)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。