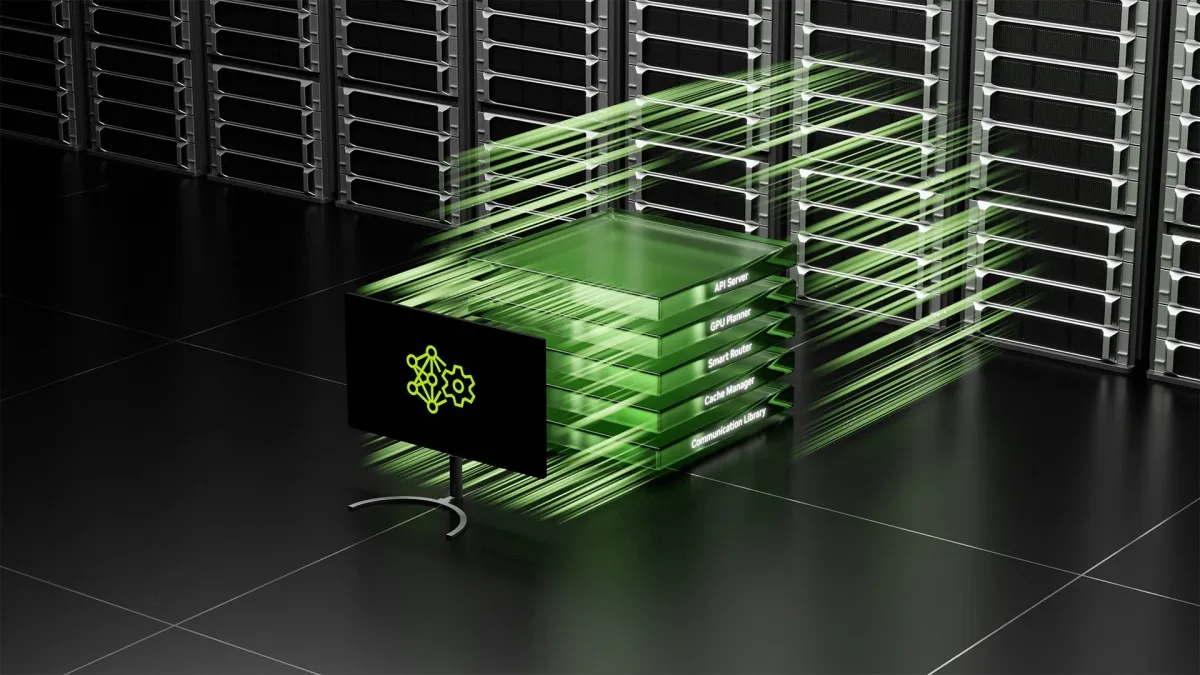

NVIDIA Dynamoが実現するAI推論の効率化と高速化

NVIDIA DynamoがAI推論を革新

NVIDIAは、ハイパフォーマンス計算の最前線であるカリフォルニア州サンノゼで行われたGTC2025において、新しいオープンソースソフトウェア「NVIDIA Dynamo」を発表しました。この革新的なライブラリは、AIファクトリーにおけるAIリーズニングモデルの効率化を実現し、コストを抑えつつ推論性能を大幅に向上させることを目的としています。

AIファクトリーとコスト削減の重要性

AIファクトリーでは、推論リクエストを効率的にオーケストレーションし、調整することが急務です。AIリーズニングが一般化する現在、さまざまなAIモデルが非常に多くのトークンを生成するようになり、推論コストの削減と性能向上を両立させることが、サービスプロバイダーの成長を加速させるカギとなっています。NVIDIA Dynamoは、トークン収益を最大化するために設計された新しいAI推論サービスソフトウェアで、数千のGPU間で推論処理をオーケストレーションし、大規模言語モデル(LLM)の異なる処理フェーズを適切に分散させます。

なぜNVIDIA Dynamoが重要なのか

NVIDIAの創業者兼CEOであるジェンスン・フアン氏は、「AIモデルは多くの産業において常に学習し、進化し続けている。NVIDIA Dynamoは、これらのモデルを大規模に展開し、AIファクトリー全体のコスト削減と効率化を推進します」と述べています。特に、同じ数のGPUを使用する場合、DynamoはNVIDIA Hopperプラットフォーム上でLlamaモデルを処理するAIファクトリーのパフォーマンスと収益を倍増させるとされています。

推論性能向上の具体例

NVIDIA Dynamoが導入された場合、GB200 NVL72ラックでDeepSeek-R1モデルを運用すると、生成されるトークンの数がGPUあたり30倍に増加することが期待されています。この推論性能の向上を可能にするのが、「スループットの向上」と「コストの削減」です。Dynamoは、リクエスト数や種類に応じてGPUを動的に調整することで、効率的なリソース管理を行います。また、特定のGPUを指定して応答時間を短縮し、クエリを最適にルーティングします。

オープンソースの力

さらに、Dynamoは完全にオープンソースであり、企業や研究者がAIモデルを提供する方法を探求できるようになります。PyTorch、SGLang、TensorRT-LLM、vLLMに対応することで、エコシステム全体がAI推論の導入を加速することが期待されています。AWSやGoogle Cloudなど、大手クラウドサービスプロバイダーと連携することで、使用するGPU間の負荷を効率的に分散させ、トラフィックのボトルネックを解消します。

AI推論における競争力

Perplexity AIのCTOであるデニス・ヤラツ氏は、NVIDIAのGPUと推論ソフトウェアを利用することで、毎月数億件のリクエストを処理し、ユーザーが求める高いパフォーマンスを実現していると述べています。これにより、ビジネスやユーザーの要求に即応できるという期待が寄せられています。

今後の展望

NVIDIA Dynamoは、GPUの適切な割り当てを行うプランニングエンジンや、リクエストを効率的に振り分けるためのスマートルーター、低レイテンシの通信ライブラリ、さらにユーザーエクスペリエンスを意識したメモリ管理を実現しています。これにより、高度なAIモデルの効率的な拡張が可能となります。NVIDIA Dynamoは、AIファクトリーの運用がより効率的かつ効果的に行えるように設計されており、その恩恵を受けるエコシステムが広がっています。

今後のAI技術の進展において、NVIDIA Dynamoがどのように使われ、我々の生活にどのような変化をもたらすのか注目していきたいと思います。

会社情報

- 会社名

- NVIDIA

- 住所

- 東京都港区赤坂2-11-7ATT New Tower13F

- 電話番号

トピックス(IT)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。