立教大学の研究者がAI国際会議「NeurIPS 2025」に論文採択

立教大学の研究が国際会議「NeurIPS 2025」に採択

立教大学大学院人工知能科学研究科の増村翔さんと瀧雅人准教授による論文が、AI分野の国際会議「NeurIPS 2025」に採択されました。この会議は、毎年開催される機械学習の世界最高峰のイベントであり、2025年12月2日から7日にかけて米国カリフォルニア州サンディエゴで行われます。

研究の核心

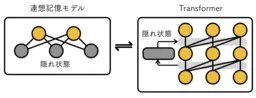

本研究では、AI研究の基盤を成すTransformerモデルの新たな発展が提案されています。従来の連想記憶モデルを拡張し、Transformerが直面する「ランク崩壊」という課題を理論的および実験的に解決したことが特徴です。この成果によって、Vision TransformerやGPTといった従来モデルの性能も向上することが確認されています。

上の画像は、右側が新しいメカニズムを持つTransformerの構成を示しており、左側は可視状態から記憶を想起するプロセスを描写しています。これにより、隠れ状態が連想記憶モデルの重要な役割を果たすことが理解されます。

連想記憶モデルの役割

連想記憶モデルは、断片的な情報から過去の完全な記憶を呼び起こす能力を持つことが特筆されます。このモデルは、1970年代から1980年代にかけて甘利俊一氏やJohn Hopfield氏により研究されてきましたが、記憶容量を拡大する方法が最近発見されました。2021年には、Transformerの自己アテンションに対応する大きな記憶容量を有する連想記憶モデルが発見され、注目が集まっています。

研究の成果

私たちの研究は、これまで知られていた連想記憶とTransformerの関係を見直し、新たな発見をもたらしました。隠れ状態への注目から、Transformerとの関係を保ちながら情報を層ごとに再帰的に伝達可能である新型Transformerが導入されました。これにより、従来の問題である「ランク崩壊」が理論的に解消され、言語生成や画像認識における性能向上が実証されました。

今後の展望

Transformerの性能向上は、従来トライアルアンドエラーに基づいて行われてきましたが、本研究は理論的指導原理の可能性を示しています。今後は、連想記憶モデルを活用し、革新的な生成AIの開発が進むことが期待されています。自然言語処理や画像認識の未来を見据えたこの研究は、AI技術のさらなる進展に寄与することでしょう。

論文情報

- - 論文タイトル: On the Role of Hidden States of Modern Hopfield Network in Transformer

- - 著者: Tsubasa Masumura, Masato Taki

立教大学の瀧雅人研究室は、AIの深層学習に関して基礎から応用まで幅広い研究を展開しており、すでに「NeurIPS 2022」や「CVPR 2024」などにも多数の論文が採択されています。

会社情報

- 会社名

- 立教大学(学校法人立教学院)

- 住所

- 電話番号

トピックス(エンタメ)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。