脳にインスパイアされた新しいAIモデル、スパイキングニューラルネットワークの進化

脳を模した新たなAIモデルの開発

最近、千葉工業大学を中心とする研究チームがスパイキングニューラルネットワーク(SNN)に新たな学習手法を取り入れ、AIの情報処理能力を飛躍的に向上させる可能性を持つ成果を発表しました。発表者の一人である山本かけい氏(マサチューセッツ工科大学)、酒見悠介氏(千葉工業大学)、合原一幸氏(東京大学)の3人は、2024年7月2日に開催された国際学会「2024 International Joint Conference on Neural Networks (IJCNN)」において、彼らの研究成果を発表しました。

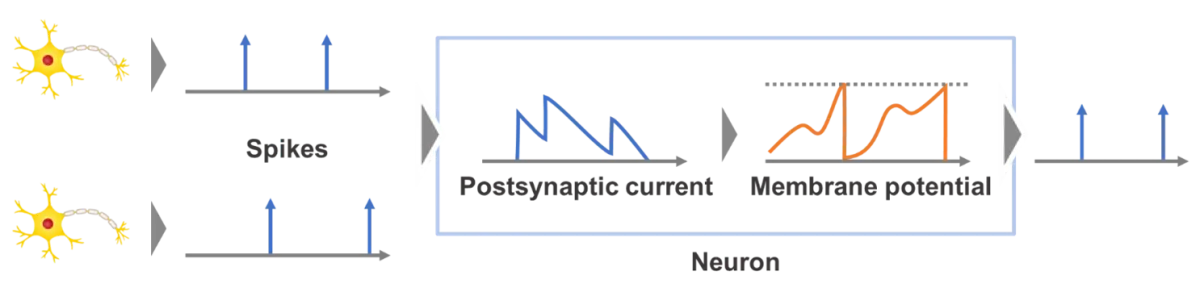

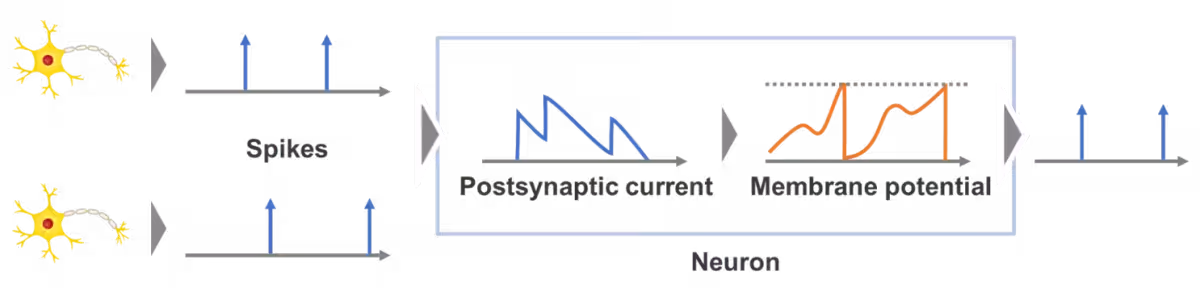

スパイキングニューラルネットワークとは

スパイキングニューラルネットワークは、生物の脳の神経回路からインスパイアを受けて開発された人工知能モデルであり、スパイクと呼ばれる不連続的な信号を用いて情報を処理します。このモデルは、従来のディープラーニングモデルと比べてエネルギー効率に優れており、特にエッジAIの分野での応用が期待されています。しかし、従来の方法では、各ニューロンが一度しか発火できないという制約があり、情報処理能力が制限されるという課題がありました。

新しい学習手法の提案

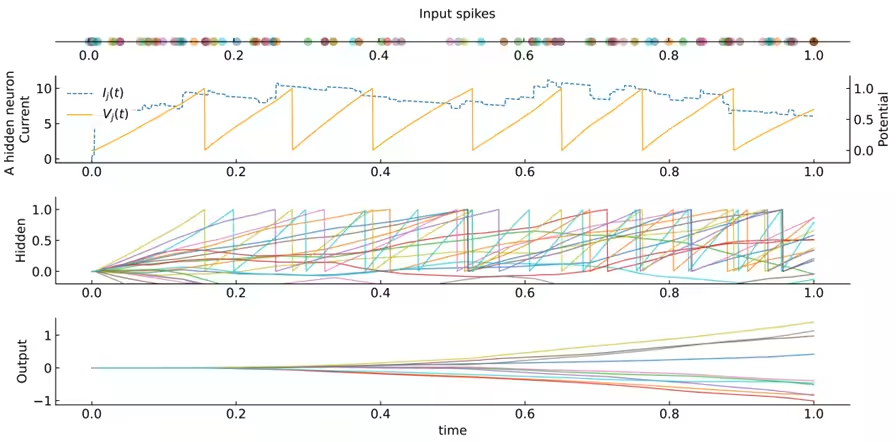

今回の研究では、発火時刻を直接学習に反映させる新たな誤差逆伝搬アルゴリズムを開発し、ニューロンが複数回発火することを可能にするmulti-spike SNNを実現しました。この手法では、ニューロンの発火時におけるシナプス電流を保持し、複数回の発火時にも効果的に学習を行うことができます。また、学習時に発火しないニューロンが発生する問題については、新たなペナルティ正則化が提案され、すべてのニューロンが参加できるように改良されました。これにより、さらに強固でロバストな学習が可能となるのです。

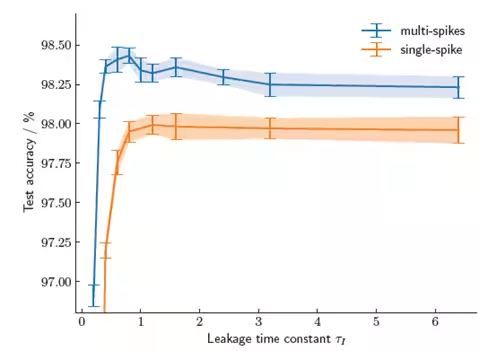

複数回発火の利点と実験結果

新しい手法により、複数回発火することができることから、SNNはより高い学習性能を得ることが可能になりました。具体的には、MNISTデータセットに対する実験では、提案したmulti-spike SNNモデルが従来のsingle-spike SNNと比べ、認識精度で優位性を示しました。また、リーク時定数が発火回数と学習性能に与える影響も調査され、特定のリーク定数の下で学習性能が最大化することが確認されました。

今後の展望

提案された学習手法は、脳型ハードウェアの開発やAIシステムにおけるエネルギー効率性を高めるための基盤として期待されています。この研究成果は、次世代の超省電力デバイスやエッジコンピューティングにおけるAI技術の進化に寄与する可能性を秘めており、今後はさらに大規模かつ複雑なタスクに対する性能向上が期待されます。さらに、今回得られた知見は、ニューロモルフィックコンピューティングにおけるハードウェア設計やアルゴリズム開発においても重要な指針を提供するでしょう。

この研究は、日本の科学技術振興基金や東京大学国際高等研究所ニューロインテリジェンス国際研究機構などからの助成を受けて実施されました。

論文情報

- - 国際学会: 2024 International Joint Conference on Neural Networks (IJCNN)

- - 論文題目: Can Timing-Based Backpropagation Overcome Single-Spike Restrictions in Spiking Neural Networks?

- - 著者: Kakei Yamamoto, Yusuke Sakemi, Kazuyuki Aihara

- - URL: IEEE Xplore

- - DOI: 10.1109/IJCNN60899.2024.10651135

会社情報

- 会社名

- 千葉工業大学

- 住所

- 千葉県習志野市津田沼2-17-1

- 電話番号

- 047-478-0222

関連リンク

サードペディア百科事典: 千葉県 千葉市 AI技術 千葉工業大学 スパイキングニューラルネットワーク

Wiki3: 千葉県 千葉市 AI技術 千葉工業大学 スパイキングニューラルネットワーク

トピックス(科学)

【記事の利用について】

タイトルと記事文章は、記事のあるページにリンクを張っていただければ、無料で利用できます。

※画像は、利用できませんのでご注意ください。

【リンクついて】

リンクフリーです。